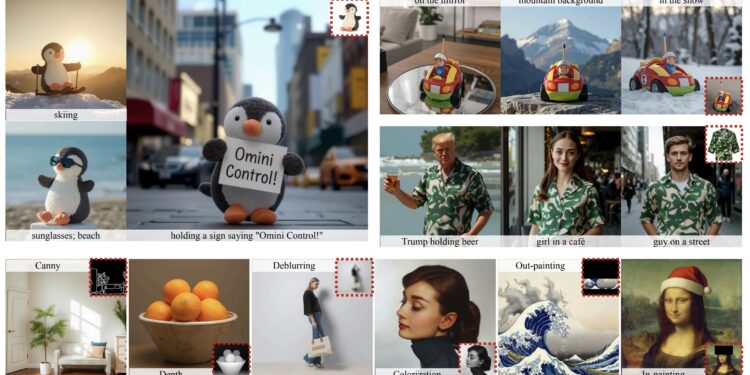

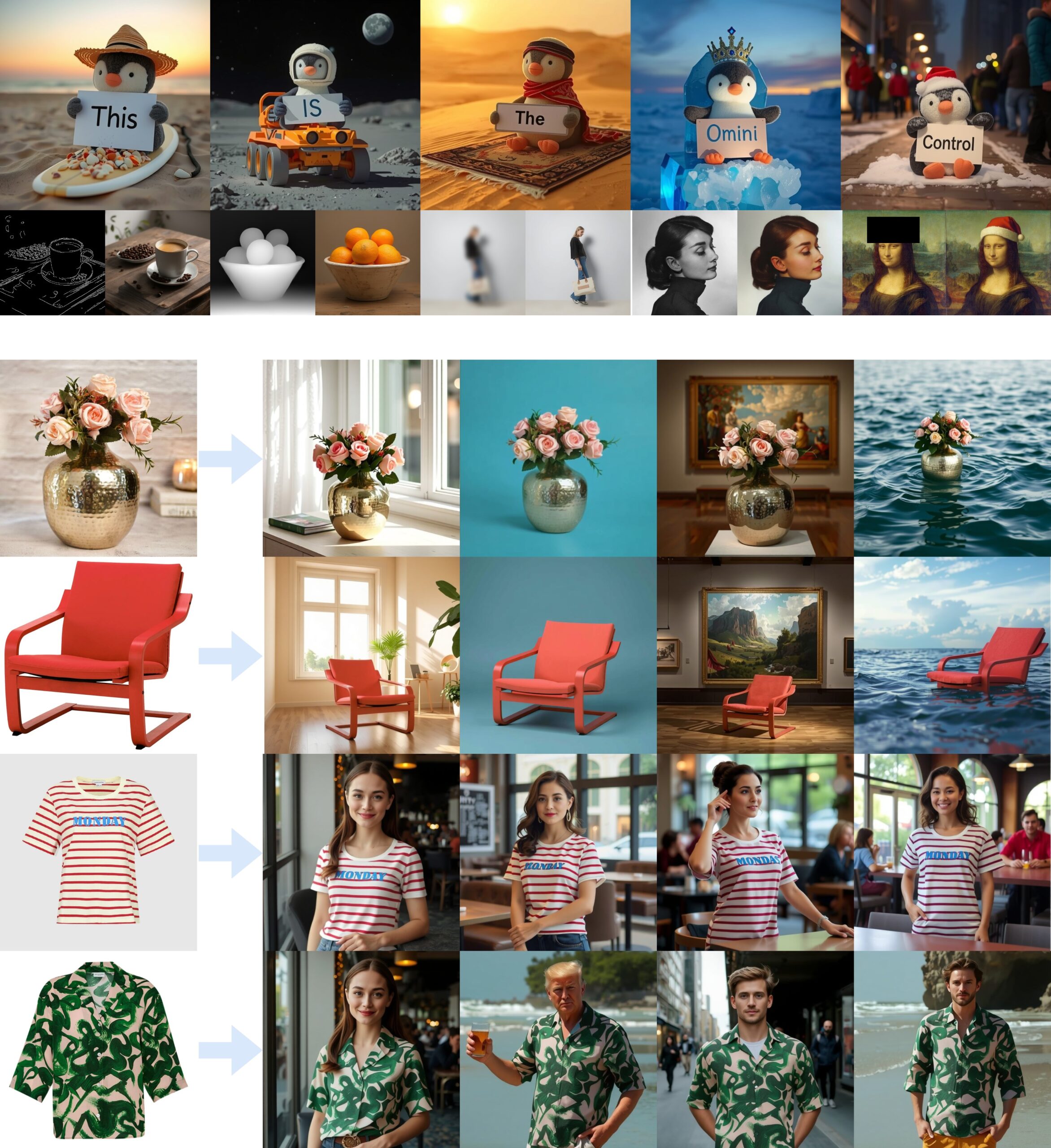

OminiControl:基于FLUX.1的通用的控制框架 通过参考图像来控制图像生成的结果

OminiControl 是一个为 FLUX.1 模型 设计的简单而通用的控制框架,由新加坡国立大学的学习与视觉实验室开发,目的是在保持模型结构最小化的同时,提供强大的控制能力。

它能在生成图片时,允许你更轻松地控制生成的结果,比如你可以通过提供一些图片信息(边缘线稿、深度图或者某个物体的图片)来指导模型,生成更符合要求的图像。

举个例子:

-

你想生成一个小猫的图片,用现有的模型可能只能输入文字描述,比如:“一只坐在椅子上的小猫”。但有时生成结果不够准确,比如椅子的样式或小猫的姿势可能不对。

-

OminiControl 让你可以进一步用参考图片或简单的草图来告诉模型:“这个椅子的样式是这样的,小猫要坐成这样的姿势。”模型可以精确地按照这些信息生成图片。

它解决了以下几个问题:

-

现有工具的局限性 :目前很多图像生成工具(比如 Stable Diffusion)虽然强大,但只能通过文字指令生成图片,而且有时候对细节控制得不够好,比如画出来的东西可能跟要求的姿势、结构对不上。

-

使用麻烦 :很多方法(如ControlNet、IP-Adapter)需要增加很多复杂的模型和代码,既占用大量计算资源,也不够灵活。

-

无法统一处理多种任务 :大部分模型只能处理特定的控制场景,用户需要为不同任务部署不同的方法,增加了系统的复杂性。

-

数据不足 :生成特定主体(比如一只玩具熊或者某个物品)的时候,往往需要专门的数据集,但现有的数据不够多,也不够好。

OminiControl 如何解决这些问题?

-

通用性和高效性 :

-

统一架构 :通过在DiT模型的多模态注意力模块中整合条件图像和噪声图像,OminiControl可以用非常少的额外资源(几乎不增加额外的参数),实现对图片生成过程的全面控制,比如生成特定风格的画或者精确的细节。

-

参数高效 :仅增加 0.1%-0.4% 的额外参数 ,远低于现有方法。

-

-

条件控制的增强 :

-

不仅支持用文字生成图片,还可以用现有图片、边缘线稿、深度信息等来指导生成,结果更加符合要求。

-

引入条件强度因子(γ),允许用户在推理过程中动态调节条件对生成结果的影响。

-

-

新数据集Subjects200K :

-

提供了一个包含 20万张高质量、身份一致性图像 的开源数据集,用于解决主体生成任务中的数据稀缺问题。特别是那些需要保持主体一致性的生成任务,比如让同一个人或物品在不同场景下保持形状和特征。

-

数据集通过自动化管道生成,具有多样性和高质量,显著提升模型的训练效果。

-

-

性能表现 :

- 在各种生成任务(如边缘到图像、深度生成、主体生成)中,OminiControl在控制能力、生成质量和效率上均优于现有方法。

OminiControl 的主要功能特点

OminiControl 是一个功能强大的图像生成控制工具,基于扩散模型(Diffusion Models)和 Transformer 架构,具备以下主要功能:

1. 多模态条件控制

-

支持不同的输入条件来指导图像生成,不仅限于文字,还包括:

-

图像线稿(Canny 边缘) :通过简单的线条描绘轮廓生成图像。

-

深度图(Depth Map) :根据深度信息生成符合透视和结构的图像。

-

遮罩(Masking) :对图像的特定区域进行修改或修复(如修补缺失部分)。

-

颜色信息(Colorization) :对黑白图片上色或对已有图像进行颜色调整。

-

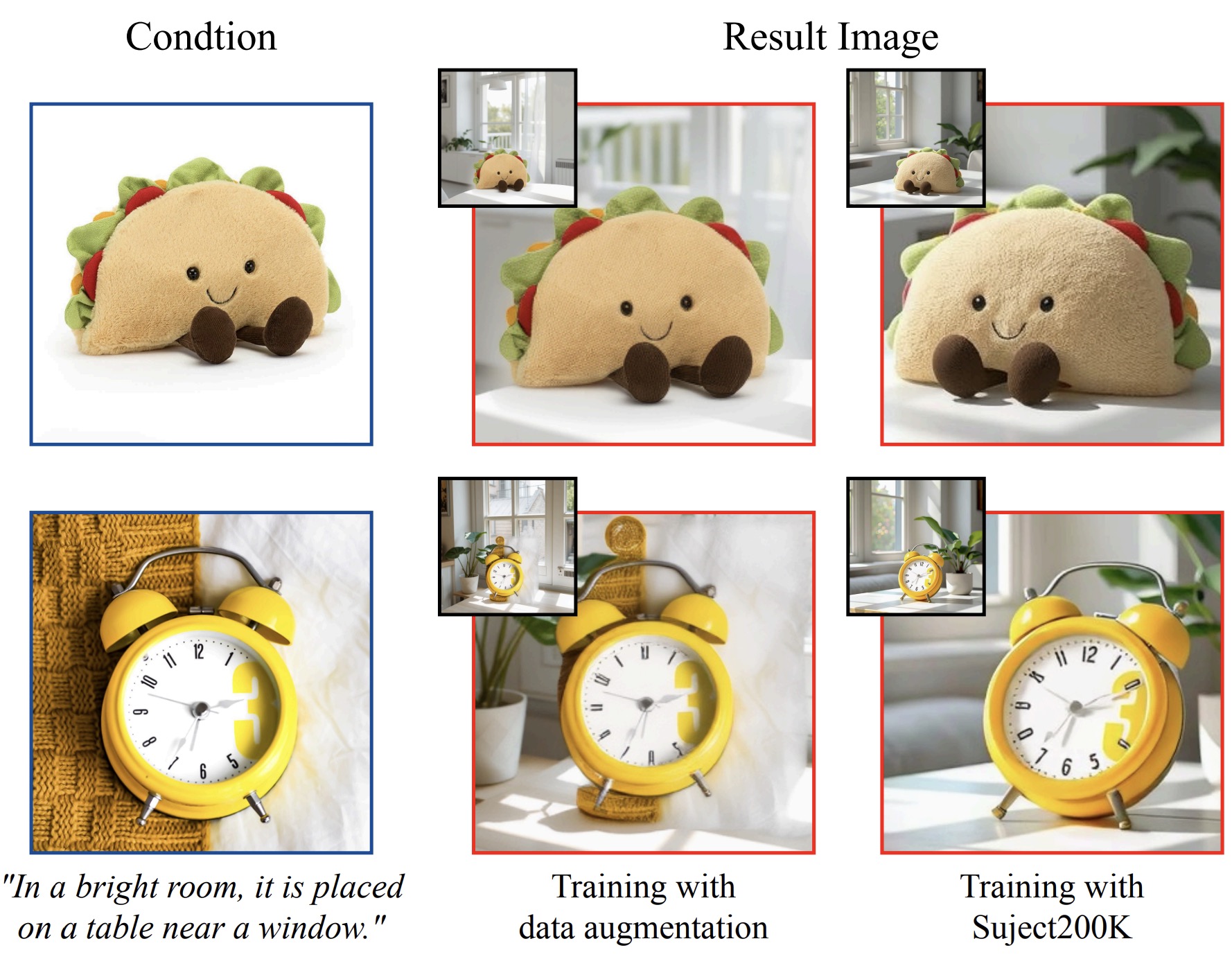

参考图片 :以给定图片为参考生成具有相同风格或主体特征的图片。

-

Prompt: The Mona Lisa is wearing a white VR headset with ‘Omini’ written on it. 提示:蒙娜丽莎戴着一副白色的虚拟现实头盔,上面写着“Omini”。

Prompt: A yellow book with the word ‘OMINI’ in large font on the cover. The text ‘for FLUX’ appears at the bottom. 提示:一本黄色的书,封面上用大字体写着“OMINI”。底部出现了“for FLUX”字样。

2. 统一控制架构

-

在一个模型中实现了对多种任务的统一支持:

-

空间对齐任务 :例如线稿到图像(sketch-to-image)或深度到图像(depth-to-image),生成的图片和输入条件空间一致。

-

非空间对齐任务 :如主体生成(subject-driven generation),可以基于一张参考图片生成多样化的同主体图片。

-

Prompt: A light gray sofa stands against a white wall, featuring a black and white geometric patterned pillow. A white side table sits next to the sofa, topped with a white adjustable desk lamp and some books. Dark hardwood flooring contrasts with the pale walls and furniture. 提示:一张浅灰色沙发靠在白色墙壁上,沙发上有一个黑白几何图案的枕头。沙发旁边放着一张白色边桌,上面放着一盏白色可调节的台灯和一些书籍。深色硬木地板与浅色墙壁和家具形成对比。

3. 条件强度调节

-

用户可以动态控制输入条件对生成结果的影响:

-

强度参数 γ :设置低值会生成更多自由样式的图片,高值则严格遵循条件。

-

灵活性:支持用户在生成过程中尝试不同的强度来调整结果。

-

4. 高效参数设计

-

仅增加 0.1%-0.4% 的额外参数,相比于现有方法(如 ControlNet、IP-Adapter)的大量参数开销更加高效。

-

避免引入额外的复杂模块,直接利用现有的 Transformer 模型完成多模态整合。

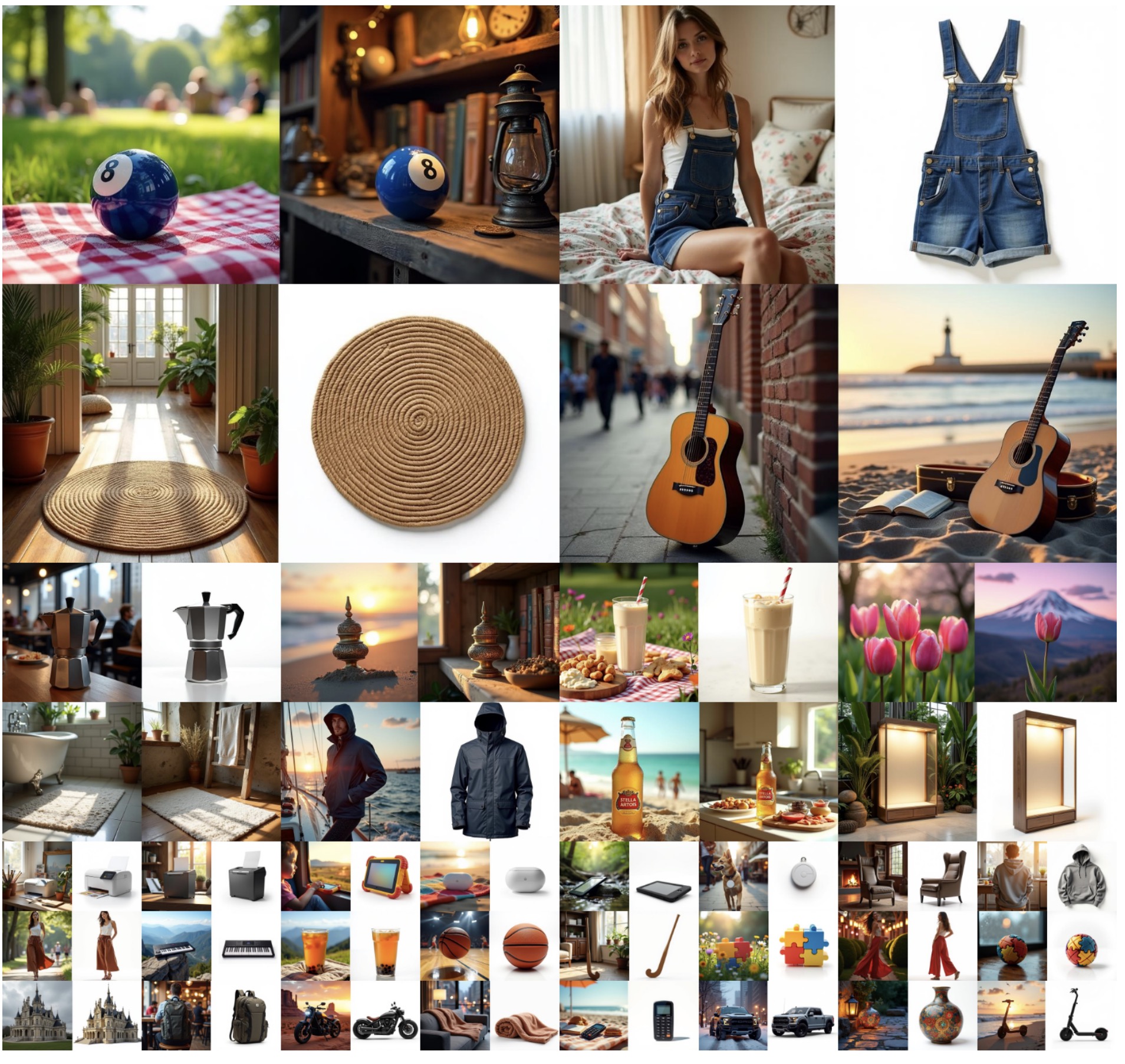

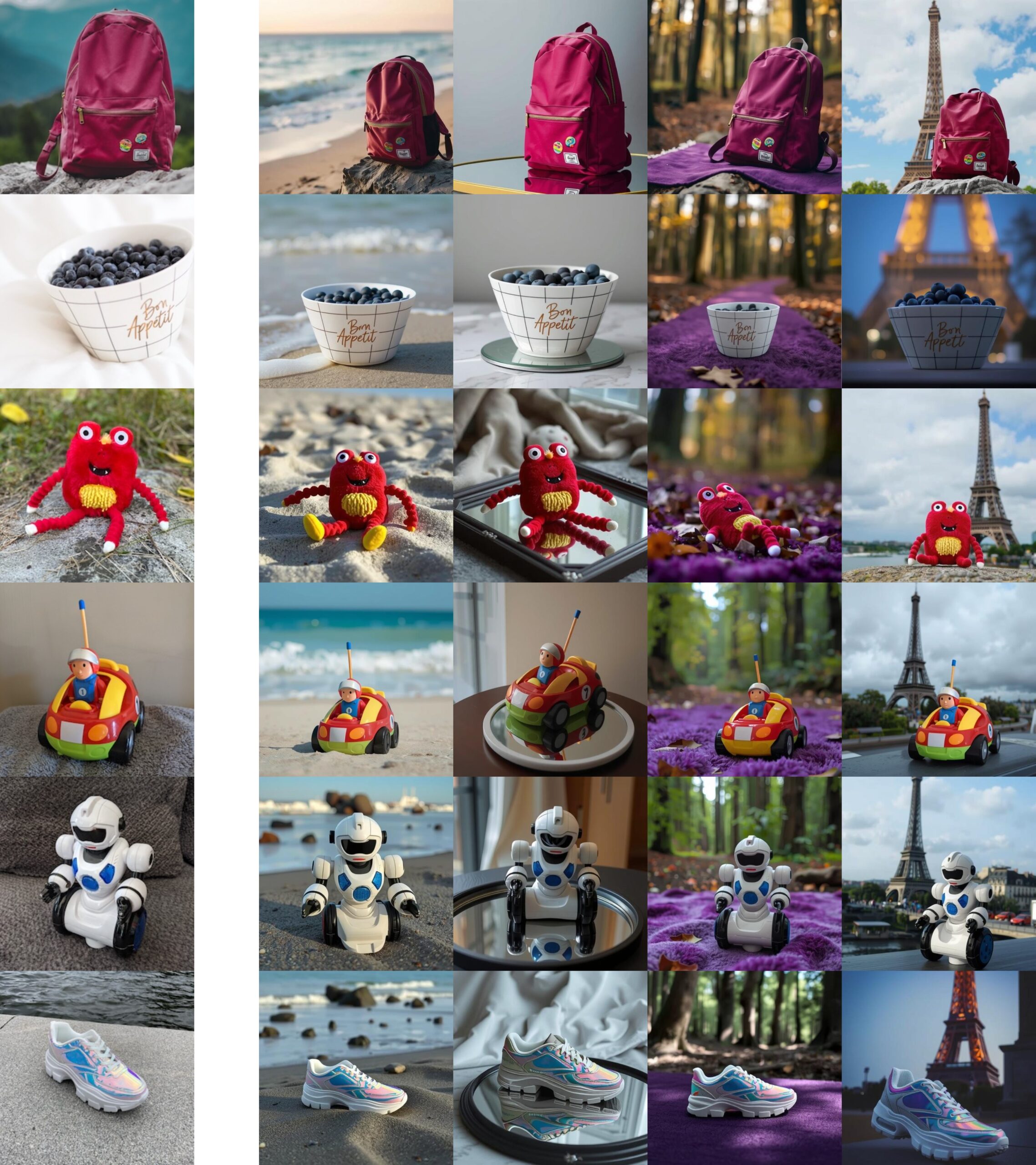

5. 数据生成与支持

-

Subjects200K 数据集 :包含 20 万张高质量、身份一致的图片数据集,帮助实现对特定主体的高质量生成(如玩偶、特定物品等)。

-

数据增强能力 :利用自动生成的描述和 FLUX 模型自动生成数据,支持多种场景和变化(如角度、光照等)。

6. 广泛的应用场景

-

边缘线稿生成艺术画 :将草图转换为高质量艺术画。

-

图片修复与上色 :修复模糊区域、补全缺失部分或对黑白图片上色。包括修复(inpainting)、边缘到图像(Canny edge to image)、深度到图像(depth to image)、图像上色(colorization)和去模糊(deblurring)。

-

个性化定制生成 :以指定的主体为核心,在不同场景生成一致性图片(如特定玩偶在不同背景的变化)。

-

风格迁移 :将一张图片的风格应用到另一张图片上。

技术方法

1. 图像条件集成 (Image Condition Integration)

-

背景 :传统方法通常将图像条件与扩散模型的隐藏状态直接叠加(如 ControlNet)。这种方式虽然在空间对齐任务中表现良好,但在非对齐任务(如主体驱动生成)中灵活性有限。

-

创新点 :

-

将图像条件视为一种与文本条件和噪声图像平等的输入,通过统一序列的方式整合这些信息。

-

统一序列处理 :图像条件经过模型的变分自动编码器 (VAE) 编码,得到潜在表示 CICI ,并与噪声图像 XX 和文本条件 CTCT 一起通过多模态注意力模块 (MM-Attention) 进行处理。

-

这种设计允许条件图像参与多模态注意力机制,无需额外的网络模块。

-

2. 自适应位置嵌入 (Adaptive Position Embedding)

-

背景 :在空间对齐任务中,条件图像的空间位置需要与输出图像严格对应,但对于非对齐任务(如主体生成),固定的位置编码会导致限制。

-

创新点 :

-

在空间对齐任务中,条件图像的位置嵌入与输出图像的位置严格对齐。

-

在非对齐任务中,通过将条件图像的位置编码与噪声图像分开处理,避免位置冲突,并加速模型收敛。

-

实验表明,这种动态调整位置的策略显著提升了模型对复杂条件的适应能力。

-

3. 条件强度因子 (Condition Strength Factor)

-

背景 :用户在实际应用中可能需要调整条件对生成结果的影响程度。

-

方法 :

-

在多模态注意力中引入偏置项 bias(γ)bias(\gamma) ,通过参数 γ\gamma 来控制图像条件的影响范围。

-

当 γ=0\gamma=0 时,忽略条件图像;当 γ=1\gamma=1 时,完全遵循条件图像;当 γ>1\gamma>1 时,增强条件的影响。

-

这种设计在训练和推理阶段均可以动态调整,提供了灵活的控制能力。

-

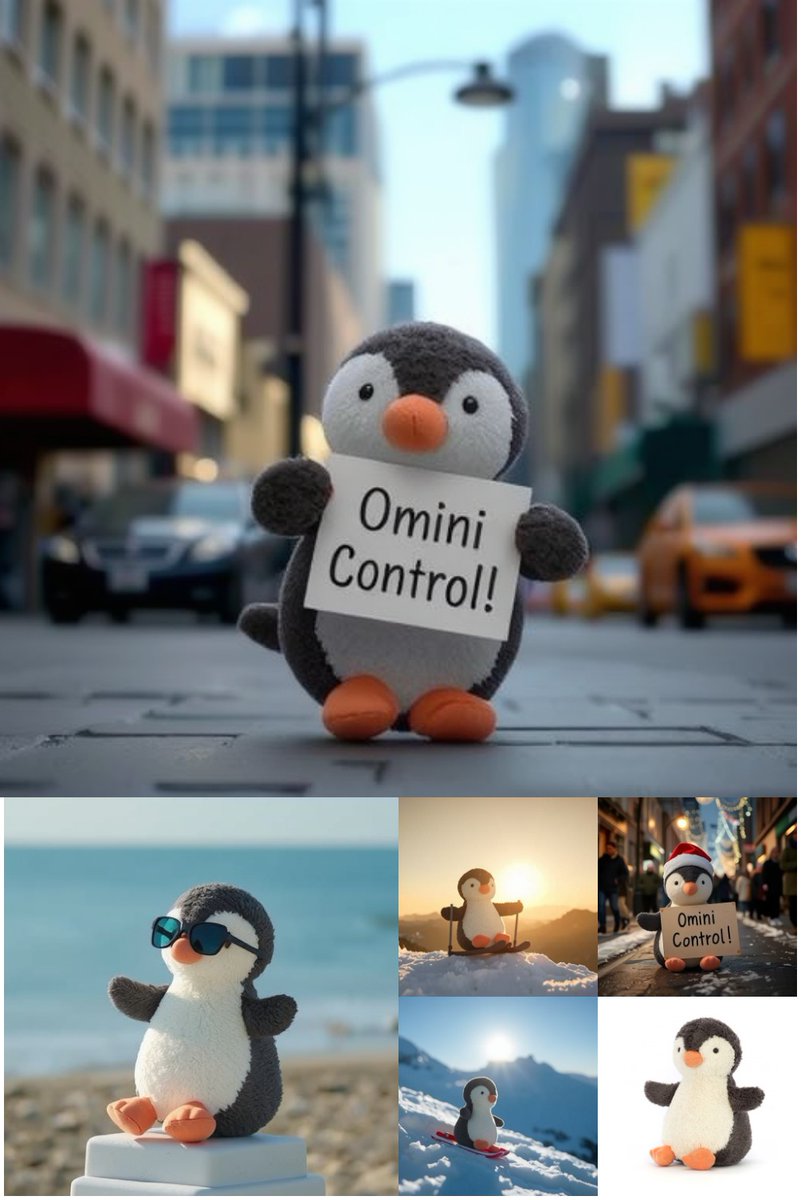

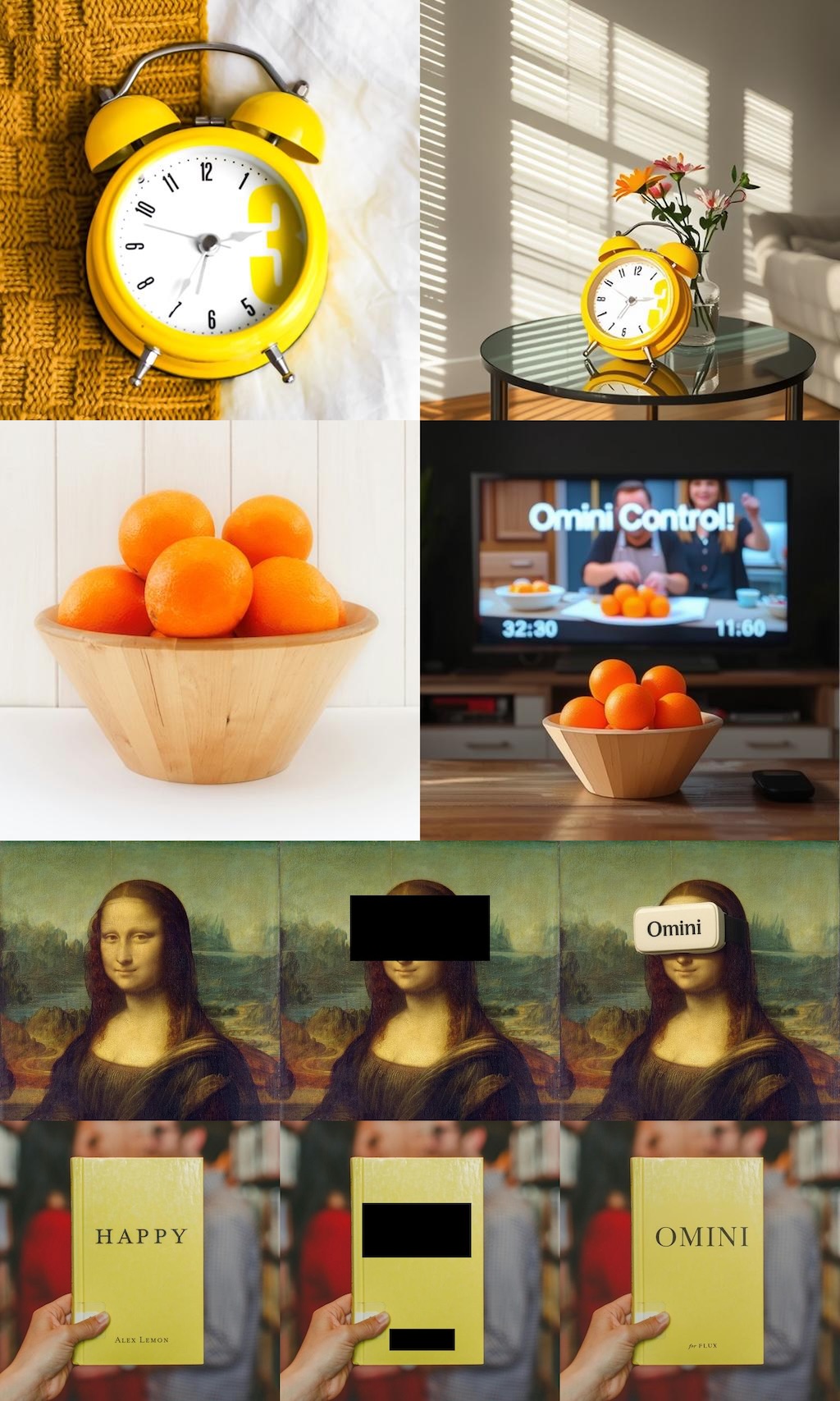

4. 数据集 Subjects200K

-

背景 :主体一致性生成任务需要高质量的数据集,而现有数据集要么规模不足,要么难以保持主体一致性。

-

方法 :

-

生成管道 :

-

使用 ChatGPT-4o 创建 20,000 条多样化的场景描述,包括 42 个对象类别和 4,696 个实例。

-

利用 FLUX.1 模型生成包含同一主体的不同视角和场景图像对。

-

通过自动化质量评估筛选出高质量样本,最终生成 20 万张图像。

-

-

优势 :相比传统数据增强方法,Subjects200K 提供了更真实的多样性,避免了因直接复制条件图像导致的过拟合问题。

-

5. 模型训练与优化

-

使用 LoRA (Low-Rank Adaptation) 进行参数高效微调:

-

默认低秩值为 4,仅对条件相关的特定参数进行调整。

-

当处理非条件相关任务时,LoRA 的缩放因子设置为 0,保留原始模型能力。

-

-

优化器采用 Prodigy ,结合 warm-up 和 bias-correction 技术提升稳定性。

-

实验使用 NVIDIA H100 GPU 进行加速,空间对齐任务训练 50,000 次迭代,主体生成任务训练 15,000 次迭代。

方法整体框架总结

-

输入 :噪声图像、文本条件、图像条件。

-

核心模块 :

-

多模态注意力机制 (MM-Attention):统一处理所有条件信息。

-

自适应位置嵌入:灵活支持空间对齐和非对齐任务。

-

条件强度控制:提供用户可调的条件影响范围。

-

-

输出 :生成与条件一致的高质量图像。

这种方法兼顾了模型的高效性、通用性和灵活性,在多种生成任务中均表现出色。

实验结果详细解读

论文通过实验证明 OminiControl 在多种图像生成任务中比现有方法表现更好,以下是实验结果的详细分析和通俗解释:

1. 空间对齐任务

这类任务要求生成的图像与输入条件(比如边缘图、深度图、模糊图像等)严格对齐,比如:

-

根据一张草图生成完整图像。

-

将模糊图像还原清晰。

-

为灰度图像添加真实感的颜色。

实验结果

研究团队在 5 个具体任务上测试了 OminiControl,发现它比传统方法(比如 ControlNet 和 T2I-Adapter)表现更好:

| 任务 | 传统方法表现 | OminiControl 的优势 |

|---|---|---|

| 边缘到图像 | 生成的图像和边缘信息一致性较低(F1=0.34) | 一致性提高到 F1=0.38 ,意味着生成的图像更符合边缘的结构。 |

| 深度到图像 | 深度图的还原不够精准(MSE=923) | 准确度提升,MSE 降到 903 ,生成的图像更贴近输入深度图的信息。 |

| 去模糊 | 模糊还原不彻底,图像看起来有残留模糊感 | MSE 从 572 降到 132 ,FID(衡量生成图像质量的指标)也从 30.38 大幅降低到 11.49 ,图像更加清晰自然。 |

| 图像上色 | 颜色不够鲜明(MSE=351) | 准确度显著提高,MSE 降到 24 ,上色后的图像更加自然鲜艳,色彩细节更加丰富。 |

传统方法的生成质量可能会出现:

-

边缘模糊 :比如画了一张猫的草图,生成的猫可能线条不够清晰。

-

颜色失真 :比如上色时颜色偏差很大,看起来很假。 而 OminiControl 能:

-

生成 更贴合输入信息 的图像,比如猫的轮廓和形态更加准确。

-

让图像的颜色、细节更加逼真,看起来更自然。

2. 主体驱动生成任务

这类任务要求根据一个参考图像(比如一个玩具或人物),生成多个新视角或新环境下的图像,同时保持主体的核心特性(比如形状、颜色、材质等)。

实验结果

OminiControl 在生成质量和一致性方面显著领先:

| 指标 | 传统方法表现 | OminiControl 的表现 |

|---|---|---|

| 身份保持率 | 传统方法只保留了 29.4% 的主体特性 | OminiControl 保留了 50.6% 的主体特性,最高达到 82.3% 。 |

| 修改准确率 | 传统方法只有 57.7% 的准确率 | OminiControl 达到 75.8% 的平均准确率,最高达到 90.7% 。 |

| 视觉自然度 | 传统方法生成的图像可能略显生硬 | OminiControl 的图像更真实,主体和背景之间的融合更加协调。 |

定性对比(生成图像的对比效果)

-

传统方法 :当输入一个玩具的照片并要求在阳光房场景生成新图像,传统方法生成的图像可能不够真实,主体特性(比如颜色和形状)丢失。

-

OminiControl :不仅准确还原玩具的颜色、形状等特性,还能生成符合阳光房场景的真实图像,整体看起来更加自然。

想象你有一个玩偶的照片,你希望 AI 根据它生成玩偶在不同房间、角度下的图片:

-

传统方法 可能会把玩偶变形,颜色变得不自然,或者看起来像是复制粘贴的结果。

-

OminiControl 能够生成更加自然和多样的图像,比如玩偶在桌子上或沙发上的不同摆放方式,看起来像真实拍摄的一样。

3. 参数效率

参数效率指模型在增加的计算量和存储量方面是否经济。增加更多的参数通常会提升模型效果,但代价是需要更多计算资源。

实验结果

| 方法 | 额外参数量(占比) |

|---|---|

| ControlNet | 增加 27.5% 的参数 |

| IP-Adapter | 增加 7.6% 的参数 |

| OminiControl | 仅增加 0.1% 的参数 |

OminiControl 只需要增加极少的计算量,却能实现更高的生成质量。相比其他方法需要较多的资源(比如显存),OminiControl 在性能和效率上做到了两全其美。

4. 数据集:Subjects200K

数据集特点

-

包含 20 万对图像 ,展示同一主体在不同场景下的多样性(如不同光线、视角)。

-

解决了传统数据增强的局限性,避免生成图像过于单一。

生成效果对比

当训练模型生成同一主体的新视角图像时:

-

传统数据增强方法 :生成的图像几乎是复制粘贴,变化不大。

-

Subjects200K :生成的图像更加丰富,比如改变了主体的光线、角度和背景,同时保持主体特性一致。

实验总结

-

生成质量 :OminiControl 在所有任务中生成的图像更加清晰、自然,细节和条件一致性显著提升。

-

控制能力 :能够灵活调整条件图像对最终结果的影响,用户体验更好。

-

效率优势 :参数增加极少,却在多个任务上超过现有方法。

GitHub: https://github.com/Yuanshi9815/OminiControl